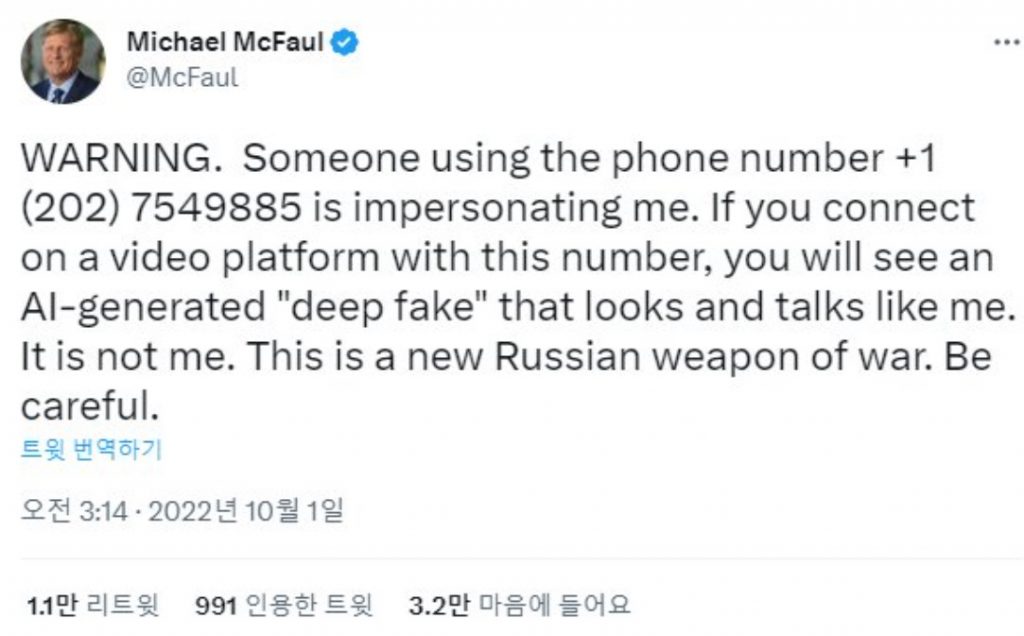

「私を盗用したディープフェイクに留意せよ」。駐ロシア米国大使を務めたマイケル・マクフォールが昨年10月、自分のツイッターアカウントを通じ、自分を真似したディープフェイクに注意するよう促す文章を載せた。

マクフォール元大使は、こうした巧妙なディープフェイクを「ロシアの新たな戦争兵器だ」と訴える。今後、単純犯罪という枠を越え、外交安保問題に飛び火する可能性もありそうだ。

ディープフェイクは「ディープラーニング(深層学習)」と「偽(Fake)」を合成した用語だ。人工知能(AI)のディープラーニングを活用して写真・映像・音声を盗用したり、複製したりする技術を言う。

3~4年前までは、人間型AIやディープフェイク・ボイスモデルを製作するためには数時間分量の録画と録音資料が必要だったが、今は写真1枚だけでも本人のように動く映像を作ることができる。

昨年の「三・一独立運動」(1919年)記念日には、ドイツマイヘリテージのディープフェイク技術を活用してネットユーザーが製作したユ・グァンスンやアン・ジュングン、ユン・ボンギルらのディープフェイク映像が流された。マイクロソフト(MS)が先月発表した音声合成技術「バリ(Vall-E)」はわずか3秒の音声ファイルで人の声を複製できる。

◇日常に食い込んだ「偽の声」…あなたもターゲット

問題はマクフォール元大使が警告した通り、このような技術の発達を犯罪に悪用しようとする人々がいるという点だ。チェ・ギョンジン人工知能法学会長(嘉泉大学法学科教授)は「技術発展により、人工知能の開発費用が大幅に下がり、参入のハードルが低くなった」と指摘。「写真1枚と1~2分の通話録音の声さえあれば、本物の人物のように動画を作れるため、犯罪に技術が悪用される事例が増えている」と話した。

業界関係者によると、有名な金融ディープフェイク犯罪では以下のような事例がある。

▽2019年3月、英国のある企業が役員の声を盗用したディープフェイク・ボイスに騙され、22万ユーロ(約3090万円)を誤って送金した。

▽2021年3月、中国国税庁の顔認識システムをディープフェイクで偽って多額を脱税した。

▽2021年10月、UAE(アラブ首長国連邦)銀行が、企業役員の声を盗用したディープフェイク・ボイスに騙されて3500万ドル(約46億円)を送金した。

政治・外交・安全保障など敏感な領域でも、虚偽情報の流布が問題になった例がある。

政治関連では、2018年、米大統領を務めたオバマ氏がトランプ大統領(当時)を誹謗中傷するディープフェイク動画が広がった。企業のセキュリティも脅かされかねない。昨年6月、米連邦捜査局(FBI)は、盗用した個人識別情報などでディープフェイクを作り、在宅・遠隔勤務を運営する企業に就職しようとする事例が多数発見されたため、注意を促す文書を配布した。

デジタル性搾取物も大きな問題だ。

代表的な事件が、韓国で2018~20年、SNS上で女性の個人情報をだまし取り、それをさらすと脅して、わいせつな動画・画像を要求した「n番部屋事件」だ。

日本ではショッピングモール、旅行会社、塾などの利用レビュー欄に、ディープフェイクを使って偽の顔写真などでレビューを作成し、評判を操作した事件も報告された。ディープフェイクはすでに日常に深く浸透している。

(つづく)

(c)MONEYTODAY