歌を聴く際、脳に現れる反応を記録し、これを人工知能(AI)に学習させて音楽を再構成する――米国の研究者が、これに成功した。脳が音楽を処理するプロセスに対する理解を深めるとともに、神経障害で言葉を話せない人の自然なコミュニケーションへの道を開くと期待されている。

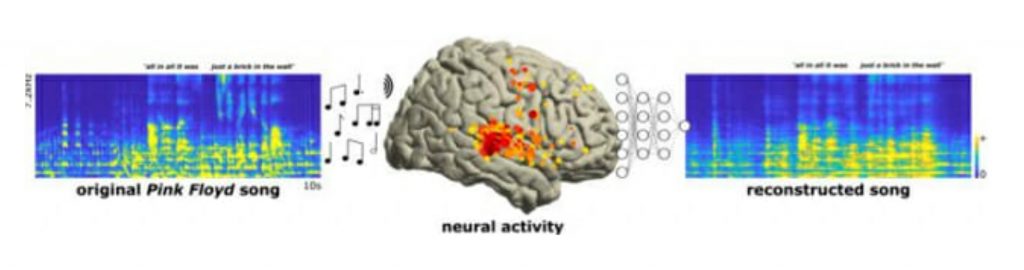

米カリフォルニア州立バークレー大学研究チームは英ロックバンド「ピンク・フロイド(Pink Floyd)」のヒット曲「Another Brick in the Wall, Part 1」を聴く際に現れた脳信号記録を分析し、こうした結果を得た。

この記録は、てんかん患者29人が脳に電極を植える手術を受けている間、歌と話し声を聴かせ、電極に現れた信号を測定したものだ。2008年と2015年に収集され、脳信号に基づいて言語を再構成する研究に使われていたもので、最近のAI技術の発達に支えられて今回は音楽まで再構成した。

研究チームは、歌を聴かせながら測定した脳信号記録をAIに学習させ、これに基づいて脳信号から再び歌をつくり出すようにした。その結果、歌の中で「All in all it was just a brick in the wall」という部分が実際の歌と似たように再現された。リズムと歌詞はかなりつぶれたものの、識別可能な水準にはなった。

バークレー大のロバート・ナイト教授は「この研究を通じて、脳の音楽処理に対する理解という大きな壁に、小さなれんがを一つ積み上げた」と表現している。この研究は学術誌「PLOS Biology」に最近掲載された。

(c)KOREA WAVE