アプリマーケットで「AI顔スワップ」と入力すると、多くの外国製アプリが表示された。その中から、ダウンロード数が5000万回以上の人気アプリをダウンロードした。アプリ購入費も別途かからない。アプリを起動すると、多くの映像テンプレートが用意されていた。緑色のスポーツウェアを着た男性が手振りを交えて踊る映像に、自分の写真を合成してみることにした。映像の制作も無料で、最大30秒の広告を視聴するだけでよかった。

セルフィーを1枚撮影してから10秒ほどで、自分の顔が映り込んだ映像が完成した。見た人が、私が実際にショートフォームコンテンツを撮影したと誤解するほど自然な仕上がりだった。その映像を通信アプリ「カカオトーク」で両親に送ると、「髪型が違っていたら混乱したかもしれない」という反応が返ってきた。この反応に、面白さよりも不安が先立った。SNSで簡単に共有できるだけに、誰かが私の顔で合成映像を作っているのではないかという不安がよぎった。

韓国で最近、女性の顔にポルノを合成した編集物が流布される、いわゆる「ディープフェイク」性犯罪が拡大し、当局が緊急対応を迫られる中、非専門家でも簡単にディープフェイク映像を制作できるサービスが少なくないことが判明した。

実際、これらのサービスは友人や知人とのコミュニケーションを目的とした娯楽や新たな創作を名目に開発されたが、初心者でもデジタル性犯罪(ポルノ合成)やフィッシング犯罪(サイバー詐欺)に容易に悪用できるという問題がある。AIの進歩に伴う文明の利器である一方で、新たな犯罪道具になりかねないという危険性も指摘されている。

◇写真1枚を添付するだけで…巧妙な合成映像が10秒で完成

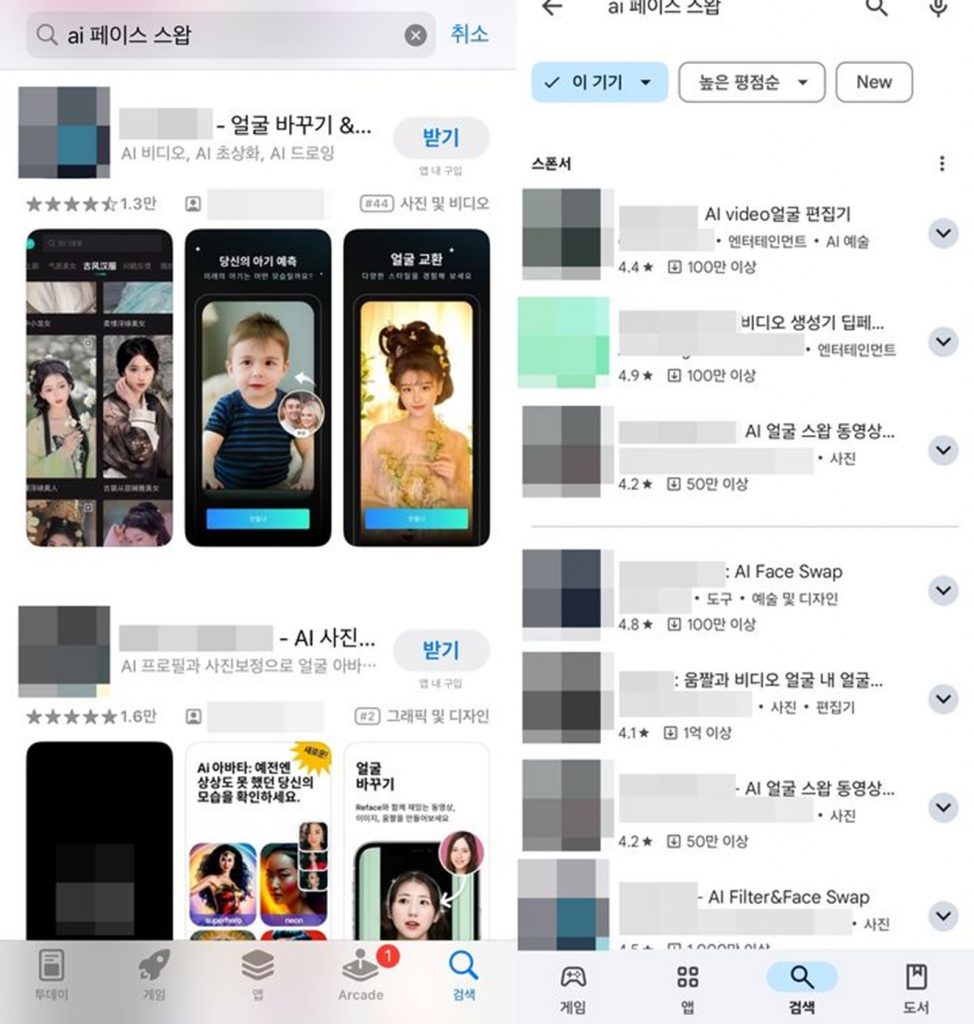

Google Playなどのスマートフォンアプリストアで「ディープフェイク」「AI顔合成」「AIフェイススワップ」などの関連キーワードを検索すると、数十個の関連サービスアプリが表示されるほど、有料・無料のAI映像編集プログラムが流通している。誰でも簡単にスマートフォンでディープフェイク映像を制作できる状況にある。これらのサービスは「顔の交換」「性別の変更」「声の変換」などの機能も提供している。

AI技術が急速に進化し、今では本物の映像と偽物の映像を見分けるのが難しいほど精巧になっている。過去のディープフェイク映像では表情や動作が不自然なものが多かったが、最近では専門家でも注意深く見なければ偽物を見分けることが難しい。

記者が実際にあるアプリを使ってディープフェイク映像を制作してみた。2020年にリリースされたこのアプリは、あるアプリマーケットで5000万回以上ダウンロードされた人気のディープフェイク映像制作アプリの1つだ。このアプリは、広告を視聴することでディープフェイク映像を制作でき、合成したい映像テンプレートに記者の顔写真を添付すると、約10秒で映像が完成した。

この映像は利用者のスマートフォンに保存され、インスタグラムやフェイスブック、カカオトークなどでも共有できる。有料会員になると、AIが作成したという表示も削除できる。

その他にも、世界中で1億回以上ダウンロードされたディープフェイク映像制作アプリも存在していた。これらのアプリを調べると、会員登録や利用規約への同意といった手続きもなく映像を制作できるのが特徴だった。特に、同意なく他人の写真を無断で使用して映像を作成し、摘発された場合の利用制限についての案内もなかった。

さらに、特定のテレグラムチャンネルに写真1枚を送信し、利用料を支払うと、わずか3秒で裸の写真に合成してくれるプログラムボットも登場し、物議を醸している。

◇AIディープフェイクの二面性…文明の利器 vs 犯罪道具

今後さらに問題となるのは、AI技術がテキストデータに加え、映像・音声データも包括的に処理するマルチモーダル方式へと進化していることだ。2024年2月に「ChatGPT」を開発したOpenAIは、簡単なテキストを入力するだけで最大1分間の高画質映像を生成する次世代生成AI「Sora」を発表し、映像業界で注目を集めた。

この技術が犯罪に悪用されると、深刻な状況を引き起こす可能性がある。

これまでディープフェイク技術は特定の人物を他の映像に合成するレベルにとどまっていたが、今では特定のシナリオを作成して虚偽の映像を創作することも可能であるという指摘がある。

デジタル性犯罪も問題だが、ディープフェイク技術が金銭問題と直結するフィッシング犯罪にも悪用される可能性が高い。

例えば、知り合いから送られてきた挨拶メールを偽装することができ、短い挨拶文を用いた複製された音声は、家族を騙して身代金を要求する際に利用される可能性があると、セキュリティ専門家は警告している。

肉眼で真偽を判断するのが難しい。それほどディープフェイク映像技術が進歩しており、それを悪用する犯罪も急速に増加している。なのに、それを抑制する方法が十分に整っていないのが現状だ。

ソウル女子大学情報保護学科のキム・ミョンジュ教授は「ディープフェイクはコンテンツ制作などで利便性を提供するため、すべてのディープフェイク写真・映像制作アプリを規制することは不可能だ」と指摘する。ディープフェイクの副作用に対する軽率な規制が「害虫を駆除するために家を焼く愚行」になる可能性があるとの見方もある。

専門家らは、ディープフェイク技術の革新に支障を来さないようにしつつ、副作用を最小限に抑える制度的な措置が必要であることに同意している。

青少年がディープフェイク技術とその危険性を十分に認識し、正しく活用できるメディアリテラシーの教育が切実に求められている。

また、ディープフェイクの開発者やソーシャルメディア、コンテンツ共有プラットフォームの運営者も、開発段階からディープフェイクの悪用可能性を最小限に抑え、誤用されたディープフェイク映像を判別し、遮断できる管理策を講じるべきだ。

専門家は何よりも、ソーシャルネットワークに個人情報を過度に保存しないよう勧告している。ソーシャルネットワークサイトにアップロードされた写真や音声データが多ければ多いほど、偽の映像もより精巧になるからだ。【NEWSIS ユン・ジョンミン記者】

(c)NEWSIS